ปัญญาประดิษฐ์ (AI : Artificial Intelligence) คือ

เครื่องจักร(machine) ที่มีฟังก์ชันทีมีความสามารถในการทำความเข้าใจ เรียนรู้องค์ความรู้ต่างๆ อาทิเช่น การรับรู้ การเรียนรู้ การให้เหตุผล และการแก้ปัญหาต่างๆ เครื่องจักรที่มีความสามารถเหล่านี้ก็ถือว่าเป็น ปัญญาประดิษฐ์ (AI : Artificial Intelligence) นั่นเอง

เพราะฉะนั้นจึงสามารถกล่าวได้ว่า AI ถือกำเนิดขึ้นเมื่อเครื่องจักรมีความสามารถที่จะเรียนรู้นั่นเอง ซึ่ง AI ก็ถูกแบ่งออกเป็นหลายระดับตามความสามารถหรือความฉลาด โดยจะวัดจากความสามารถในการ ให้เหตุผล การพูด และทัศนคติของ AI ตัวนั้นๆ เมื่อเปรียบเทียบกับมนุษย์อย่างเราๆ

AI ถูกจำแนกเป็น 3 ระดับตามความสามารถหรือความฉลาดดังนี้

1 ) ปัญญาประดิษฐ์เชิงแคบ (Narrow AI ) หรือ ปัญญาประดิษฐ์แบบอ่อน (Weak AI) : คือ AI ที่มีความสามารถเฉพาะทางได้ดีกว่ามนุษย์(เป็นที่มาของคำว่า Narrow(แคบ) ก็คือ AI ที่เก่งในเรื่องเเคบๆหรือเรื่องเฉพาะทางนั่นเอง) อาทิ เช่น AI ที่ช่วยในการผ่าตัด(AI-assisted robotic surgery) ที่อาจจะเชี่ยวชาญเรื่องการผ่าตัดกว่าคุณหมอยุคปัจจุบัน แต่แน่นอนว่า AIตัวนี้ไม่สามารถที่จะทำอาหาร ร้องเพลง หรือทำสิ่งอื่นที่นอกเหนือจากการผ่าตัดได้นั่นเอง ซึ่งผลงานวิจัยด้าน AI ณ ปัจจุบัน ยังอยู่ที่ระดับนี้

2 ) ปัญญาประดิษฐ์ทั่วไป (General AI ) : คือ AI ที่มีความสามารถระดับเดียวกับมนุษย์ สามารถทำทุกๆอย่างที่มนุษย์ทำได้และได้ประสิทธิภาพที่ใกล้เคียงกับมนุษย์

3) ปัญญาประดิษฐ์แบบเข้ม (Strong AI ) : คือ AI ที่มีความสามารถเหนือมนุษย์ในหลายๆด้าน

จะเห็นได้ว่าวิทยาการของมนุษย์ปัจจุบันอยู่ที่จุดเริ่มต้นของ AI เพียงเท่านั้น

ปัจจุบัน ได้มีการนำ AI มาใช้ในอุตสาหกรรมจำนวนมาก โดย "แมคคินซีย์แอนด์คอมปะนี (McKinsey & Company) " (บริษัทที่ปรึกษาด้านการบริหารชั้นนำของโลก ) ได้กล่าวไว้ว่า " AI มีศักยภาพในการทำเงินได้ถึง 600 ล้านดอลล่าร์สหรัฐในการขายปลีก สร้างรายได้มากขึ้น 50 เปอร์เซนต์ในการธนาคารเมื่อเทียบกับการใช้เทคนิควิเคราะห์เเบบอื่นๆ และสร้างรายได้มากกว่า 89 เปอร์เซนต์ ในการขนส่งและคมนาคม "

ยิ่งไปกว่านั้น หากฝ่ายการตลาดขององค์กรต่างๆ หันมาใช่ AI จะเป็นการเพิ่มศักยภาพให้กับการทำงานด้านการตลาดอย่างมาก เพราะว่า AI สามารถที่จะทำงานที่ซ้ำซากได้อย่างอัตโนมัติ ส่งผลให้ตัวแทนจำหน่าย สามารถที่จะโฟกัสไปที่การสนทนากับลูกค้า อาทิเช่น บริษัทนามว่า " Gong " มีบริการที่เรียกว่า "conversation intelligence" , โดยทุกๆครั้งที่ตัวแทนจำหน่ายต่อสายคุยโทรศัพท์กับลูกค้า AIจะทำหน้าที่ในการบันทึกเสียงเเละวิเคราะห์ลูกค้าในขณะเดียวกัน มันสามารถแนะนำได้ว่าลูกค้าต้องการอะไร ควรจะคุยเเบบไหน ถือเป็นการซื้อใจลูกค้าอย่างหนึ่ง

โดยสรุป , ปัญญาประดิษฐ์หรือ AI เป็นเทคโนโลยีที่ล้ำสมัยที่สามารถรับมือกับปัญหาที่ซับซ้อนเกินกว่าที่มนุษย์จะสามารถรับมือได้ เเละ AI ยังเป็นเครื่องมือที่สามารถทำงานที่ซ้ำซากน่าเบื่อแทนมนุษย์ได้อย่างดีเยี่ยม ช่วยให้เราสามารถมีเวลาไปโฟกัสงานที่สำคัญและสามารถสร้างมูลค่าได้มากกว่า นอกจากนี้การประยุกต์ใช้ AI ในระดับอุตสาหกรรม ยังช่วยลดต้นทุนเเละเพิ่มรายได้มหาศาล

ประวัติย่อของ AI

AI เป็นคำยอดฮิตที่ปัจจุบัน แม้ว่ามันไม่มันจะไม่ใช่คำที่เพิ่งถูกบัญญัติขึ้นมาใหม่แต่อย่างใด ในปี 1956 , กลุ่มของผู้เชี่ยวชาญแนวหน้าจากหลายๆวงการได้ร่วมกันทำงานวิจัยเกี่ยวกับ AI มีผู้นำทีมได้แก่ John McCarthy (Dartmouth College), Marvin Minsky (Harvard University), Nathaniel Rochester (IBM) และ Claude Shannon (Bell Telephone Laboratories) โดยมีจุดประสงค์หลักของงานวิจัย คือ การค้นหามุมมองและหลักการต่างๆที่ใช้การเรียนรู้อย่างครอบคลุมเพื่อที่จะนำมาประยุกต์ใช้ให้เครื่องจักรสามารถเรียนรู้ได้เช่นกัน

โดยมีเนื้อหาของโครงการมีดังนี้

1.) คอมพิวเตอร์อัตโนมัติ (Automatic Computers)

2.) จะสามารถเขียนโปรเเกรมคอมพิวเตอร์โดยใช้ภาษาคอมพิวเตอร์ได้อย่างไร ( How Can a Computer Be Programmed to Use a Language?)

3.) โครงข่ายประสาทเทียม (Neural Nets )

4.) การพัฒนาด้วยตนเอง (Self-improvement )

องค์ความรู้เหล่านี้เป็นองค์ความรู้พื้นฐานที่ทำให้คอมพิวเตอร์มีความฉลาดมากขึ้น และยังทำให้ความคิดที่จะการสร้าง AI มีความเป็นไปได้มากยิ่งขึ้น

ชนิดของ AI (Type of Artificial Intelligence) AI ถูกแบ่งออกเป็น 3 sub field ได้แก่

1) ปัญญาประดิษฐ์ (Artificial Intelligence)

2) การเรียนรู้ของเครื่อง (Machine learning)

3) การเรียนรู้เชิงลึก (Deep Learning)

Machine Learning คือ ศาสตร์ของการศึกษา วิธีการคิด ( algorithm ) ที่ใช้ในการเรียนรู้ (learn) จากตัวอย่าง (example) และ ประสบการณ์ (experience) โดยมีพื้นฐานมาจากหลักการที่เชื่อว่า ทุกสิ่งอย่างมีรูปแบบหรือแบบแผน ( pattern ) ที่สามารถบ่งบอกความเป็นไปของสิ่งนั้นๆ ซึ่งเราสามารถที่จะนำแบบแผนนี้ มาประยุกต์ใช้เพื่อทำการทำนายถึงความเป็นไปในอนาคตได้ ( prediction ) อาทิเช่น การใช้ machine learning ในการทำนายราคาหุ้นในอนาคต จากข้อมูลกราฟในอดีตและปัจจุบัน

Deep Learning

เป็นซับเซตของ Machine Learning โดย Deep Learning นั้นไม่ได้หมายความว่า มันคือการทำความเข้าใจองค์ความรู้( knowledge)ในเชิงลึก แต่หมายถึงการที่เครื่องจักร(machine)ใช้หลายๆเลเยอร์(layer)ที่แตกต่างกัน ในการทำความเข้าใจหรือเรียนรู้ข้อมูล โดยความซับซ้อนของโมเดล(model) ก็แปรผันตามจำนวนของเลเยอร์(layer) ยกตัวอย่างเช่น บริษัทกูเกิล ใช้ LeNet model ในการวิเคราะห์และทำความเข้าใจภาพ (Image recognition) โดยมีการใช้เลเยอร์ทั้งหมด 22 เลเยอร์ โดยใน Deep learning , จะมีเฟสของการเรียนรู้ ( learning phase )ที่ถูกสร้างขึ้นโดย Neural Network ซึ่งอาจเรียกได้ว่าเป็นสถาปัตยกรรมของ layer ที่แต่ละ layer ซ้อนทับกันอยู่ ( stack )

AI vs. Machine Learning

ในปัจจุบัน อุปกรณ์(device)ที่เราใช้ในชีวิตประจำวัน ไม่ว่าจะเป็นสมาร์ทโฟน หรือ เเม้กระทั้งอินเทอร์เน็ตก็มีการประยุกต์ใช้ AI ในหลายครั้งๆ เวลาที่บริษัทใหญ่ๆจะประกาศให้โลกรับรู้ถึงนวัตกรรมใหม่สุดของพวกเขา พวกเขามักจะใช้คำว่า AI หรือ machine learning เสมือนว่ามันเป็นคำที่ใช้เเทนกันได้ แต่อันที่จริงเเล้ว AI กับ machine learning นั้นมีข้อแตกต่างกันบางประการ

" AI- artificial intelligence คือ วิทยาศาสตร์ของการฝึกฝน (train) เครื่องจักร (machine ) โดยมีจุดประสงค์เพื่อแก้ไขปัญหาของมนุษย์ " ถูกนิยามเมื่อ 1950s เมื่อเหล่านักวิทยาศาสตร์เริ่มให้ความสนใจกับปัญหาที่ว่า "คอมพิวเตอร์สามารถแก้ไขปัญหาด้วยตัวเองได้อย่างไร" (how computers could solve problems on their own.)

ถ้าจะให้อธิบายอย่างง่ายๆ AI ก็คือ คอมพิวเตอร์ที่มีคุณสมบัติและความสามารถคล้ายมนุษย์อีกทั้งยังสามารถทำงานได้อย่างลงตัว (seamlessly) หรือ อาจเรียกได้ว่า AI ก็คือ วิทยาศาสตร์ของการเลียนแบบทักษะของมนุษย์

Machine learning เป็นเพียงซับเซ็ตของ AI ที่จะเจาะจงไปที่การฝึกฝน(train)เครื่องจักร(machine) โดย machine ก็จะพยายามหารูปแบบ(pattern)ต่างๆของข้อมูล(input data )ที่ถูกใส่เข้ามาเพื่อในการ train , กล่าวโดยสรุป เราไม่จำเป็นต้องเขียนโปรแกรมหรือสร้าง modelขึ้นมาเอง สิ่งที่เราต้องทำก็ให้ข้อมูลหรือตัวอย่างกับตัว machine เพราะว่า machine จะพยายามสร้าง model ที่ใช้วิเคราะห์ pattern ของข้อมูลที่ได้จากการ train โดยตัวของมันเอง ( เป็นที่มาของคำว่า machine learning นั่นเอง )

แล้ว AI ถูกใช้ที่ไหนบ้าง

ปัจจุบัน ได้มีการนำ AI มาประยุกต์ใช้อย่างกว้างขวาง อาทิเช่น

การนำเอา AI ไปประยุกต์ใช้ในงานที่ซ้ำซ้อน ยกตัวอย่างเช่น AI ในกระบวนการผลิตต่างๆ ซึ่งเป็นงานต้องใช้ความปราณีต เเละ ทำเหมือนเดิมตลอดเวลา(จนกว่าจะมีการเปลี่ยนแปลงกระบวนการผลิต ) การนำ AI มาประยุกต์ใช้จะช่วยเพิ่มผลผลิต เเละ ยังลดตวามผิดพลาดในการผลิต เพราะว่า AI ไม่จำเป็นต้องพักและไม่มีความรู้สึกเหนื่อยล้าอีกทั้งยังไม่มีความรู้สึกเบื่อหน่ายต่องานที่ทำ

การนำเอา AI มาพัฒนาผลิตภัณฑ์(product)ที่มีอยู่แล้ว ก่อนจะถึงยุคของ machine learning , product มักจะอยู่ในรูปแบบของโค้ดเเต่เพียงอย่างเดียว อยากได้อะไร มีฟังก์ชันเเบบไหน ก็ต้องลงมือทำขึ้นมาเองทั้งสิ้น ( hard-code rule ) . ลองนึกถึง facebook สมัยก่อน ที่เวลาเราอัพโหลดรูปภาพ เราต้องเสียเวลามานั่งแท็กเพื่อนทีละคนๆ แต่ปัจจุบัน facebook มี AI ที่ช่วยในการแท็กรูปได้อย่างอัตโนมัติ

ปัจจุบัน AI ได้ถูกนำมาประยุกต์ใช้ในเกือบทุกอุตสาหกรรม ตั้งแต่ระดับการตลาด(marketing) ไปถึงระดับห่วงโซ่อุปทาน(supply chain ) , การเงิน (finance ) , การกระบวนการทำอาหาร (food-processing sector ) จากผลสำรวจของบริษัท McKinsey พบว่า การให้บริการให้การเงิน (financial services ) และการสื่อสารด้วยเทคโนโลยีล้ำสมัย ( high tech communication ) เป็นด้านที่มีการใช้ AI เป็นระดับแนวหน้า เมื่อเทียบกับด้านอื่นๆ

ทำไม AI ถึงเป็นเทรนด์ที่มาแรงในปัจจุบัน

neural network เป็องค์ความรู้ที่เกิดขึ้นตั้งเเต่ปี 1990s จากผลงานวิจัยของคุณ Yann LeCun แต่อย่างไรก็ตาม neural network ก็เพิ่งมาเป็นที่นิยมเมื่อปี 2012 ทำไมถึงเป็นเช่นนั้น ? เราจะอธิบายให้ฟังถึง 3 ปัจจัย ดังต่อไปนี้

1 ) Hardware

2) Data

3) Algorithm

Machine learning นั้นก็เป็นศาสตร์แห่งการทดลองและลงมือทำศาสตร์ เราจำเป็นต้องหาข้อมูลและวิธีการต่างๆจำนวนมากเพื่อมาทำการ train หลังจากที่กระแสการใช้งานอินเทอร์เน็ตถูกแผร่หลาย ข้อมูลต่างๆก็สามารถเข้าถึงได้ง่ายขึ้น นอกจากนี้เรื่อง CPU หรือ GPU ที่ใช้ในการประมวลผลก็สำคัญในการใช้ train และ test model ต่างๆ ซึ่งปัจจุบันก็มี GPU gaming ที่มีเสปคที่สูง วางขายอยู่ตามร้านค้าทั่วไปอีกต่างหาก เช่น GPU gaming ของ NVIDIA และ AMD

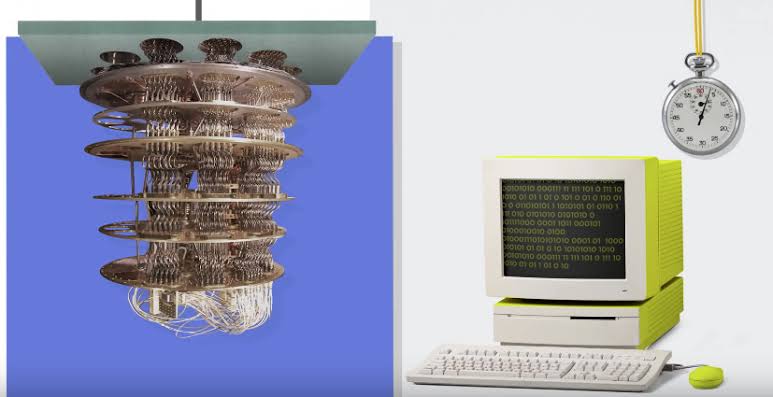

Hardware

ตลอด 20 ปีที่ผ่านมา , CPU ของเราสามารถ train deep-learning model ที่เป็น model ขนาดเล็กๆผ่านlaptop ก็จริง แต่อย่างไรก็ตาม มันไม่เพียงพอต่อการประมวลผลของ deep-learning model ที่ใช้สำหรับ computer vision หรือ deep learning ซึ่งต้องยกความดีความชอบแก่ผู้ผลิต GPU อย่าง NVIDIA และ AMD ที่สร้าง GPU รุ่นใหม่ที่สามารถทำการคำนวณหรือประมวลผลแบบคูขนานได้ ( parallel computation ) ซึ่งสามารถช่วยในการยกระดับความเร็วในการประมวลผลอย่างมาก

ตัวอย่างเช่น NVIDIA TITAN X ใช้เวลาเพียง 2 วันในการ train model " ImageNet " ซึ่ง CPU แบบดั่งเดิมใช้เวลาถึงหลายสัปดาห์ , นอกเหนือจากนี้ บริษัทใหญ่ๆหลายบริษัทเลือกที่จะใช้ cluster of GPU ในการ train deep learning model โดยใช้เป็น NVIDIA Tesla K80 เพราะว่าจะช่วยลดต้นทุนในการดูแลรักษาศูนย์ข้อมูล (data center ) อีกทั้งยังได้ประสิทธิภาพที่ดียิ่งขึ้น

Data

ถ้าเปรียบ neural network เป็นรถยนต์ (model นั้นๆ) ข้อมูล(data) ก็เปรียบเสมือนน้ำมันของ model ที่สามารถทำให้มันขับเคลื่อนได้ ปราศจากน้ำมัน (data) รถยนต์ (model )ก็ไม่สามารถทำอะไรได้เลย ปัจจุบัน เทคโนโลยีใหม่ๆได้ทำลายขีดจำกัดของการเก็บข้อมูลแบบเดิมๆ เราไม่จำเป็นต้องเก็บข้อมูลขนาดใหญ่ๆไว้ที่ data center อีกต่อไป

การปฎิวัติอินเทอร์เน็ต (internet revolution ) ทำให้สามารถที่จะเก็บและแจกจ่ายข้อมูลแหล่งข้อมูลมากมายเพื่อนำข้อมูลมาเข้า machine learning algorithm , ถ้าคุณมีประสบการณ์กับแอพลิเคชันที่เกี่ยวข้องกับการจัดการรูปภาพอย่าง Flickr หรือ Instagram คุณคงจะได้เห็นศักยภาพของ AI มาบ้าง เพราะว่า แอพพลิเคชันเหล่านี้ต้องจัดการกับการรูปภาพที่สามารถแท็กได้เป็นหลายๆล้านรูป ซึ่งรูปๆเหล่านี้ก็สามารถถูกนำมาใช้ในการ train model เพื่อทำการรับรู้และแยกแยะ (recognize) วัตถุต่างๆบนรูป ปราศจากการนำข้อมูลมาจัดเก็บก่อนแบบ

การผสมผสานระหว่าง AI และ ข้อมูลที่ดี (data) ก็เปรียบเสมือนทองคำดีๆนี่เอง เพราะว่า AI เป็นวิธีการใช้ข้อมูลได้อย่างตอบโจทย์ผู้คนได้มากที่สุด แต่ไม่ว่าบริษัทไหนก็สามารถจะมีเทคโนโลยี หรือ AI ที่ความสามารถทัดเทียมกันได้ (เทคโนโลยีเป็นสิ่งที่สามารถซื้อได้) เพราะฉะนั้นเเล้ว ข้อมูลจึงเป็นตัวแปรสำคัญมากๆ เพราะฉะนั้น บริษัทหรือองค์กรที่มีข้อมูลที่เป็นประโยชน์มากกว่าย่อมกุมความได้เปรียบ

เชื่อไหมครับว่า ข้อมูลถูกสร้างขึ้นใหม่โดยเฉลี่ยประมาณ 2.2 exabytes หรือ 2.2ล้าน gigabytes ในแต่ละวัน จึงไม่แปลกที่เหล่าบริษัททั้งหลายจะแสวงหาแหล่งข้อมูเหล่านี้มาใช้ให้เกิดประโยชน์ ( นำข้อมูลมา train model เพื่อหา pattern เพื่อ predict เรื่องนั้นๆ )

Algorithm

ถึงแม้ว่า hardware จะมีประสิทธิภาพดีกว่าเดิมหลายเท่าตัว และข้อมูลก็สามารถเข้าถึงได้ง่าย , อย่างไรก็ตาม machine learning algorithm ก็ยังเป็นสิ่งที่ต้องให้ความสำคัญอย่างมาก ทำไมถึงเป็นเช่นนั้น ? ลองภาพนึกถึง กระบวนการคิดหรือ algorithm ที่ผิดตั้งแต่การใช้ตรรกะ หรือ algorithm ที่ทำงานเเบบซ้ำซ้อนจนเกินไป ต่อให้เรามีข้อมูลหรือ hardware ที่ทรงพลังมากแค่ไหน ก็คงสร้าง model ที่มีความแม่นยำสูงๆไม่ได้ , โดย algorithm ของ neural network ที่ถูกพัฒนาให้แม่นยำมากยิ่งขึ้นนี่แหละเป็นหนึ่งในเหตุผลที่ทำให้ neural network ได้รับการยอมรับ โดย neural network แบบดั่งเดิมนั้นเป็นเพียง algorithm ที่ถูกสร้างจากการคูณ matrix แบบง่ายๆ

ยกตัวอย่าง algorithm ที่มีการใช้ใน AI อย่างแพร่หลายในปัจจุบัน เช่น progressive learning algorithm เป็น algorithm ที่ทำให้คอมพิวเตอร์เรียนรู้อยู่ตลอดเวลา ซึ่งจะช่วยในการรับมือกับปัญหาต่างๆได้อย่างดี เช่น การหาข้อผิดพลาดของระบบ และ การสร้าง chatbot ที่สามารถโต้ตอบกับเราได้ราวกับว่าคุยกับคนจริงๆ (เพราะมันเรียนรู้วิธีการโต้ตอบมาจากผู้คนที่เคย chat กับมันในอดีต )

สรุป

Artificial intelligence กับ machine learning เป็น 2 คำที่ทำให้คุณอาจสับสนได้ในตอนแรก แต่เราคาดหวังว่าเมื่อคุณได้ทำความเข้าใจเนื่้อหาของบทความ คุณจะสามารถแยกแยะ 2 คำนี้ออกจากกันได้ Artificial intelligence (AI) เป็นวิทยาศาสตร์ในการฝึกฝนเครื่องจักร( train machine )ให้มีทักษะคล้ายคลึงกับมนุษย์ โดยวิธีในการ train machine ก็มีอยู่หลากหลายวิธีการเช่นกัน ในยุคเริ่มต้นของ AI เราใช้วิธีการที่เรียกว่า hard-coded programs หรือ การเขียนโค้ดที่เป็นตรรกะทุกสิ่งอย่างที่คาดว่า machine จะเผชิญกับมัน (ให้ลองนึกภาพถึงหุ่นยนต์ที่ถูกเขียนโปรแกรมมาด้วยการใช้ if-else condition เป็นหลักพัน condition แน่นอนว่าหุ่นยนต์อาจจะสามารถทำงานได้อย่างดีภายใต้คำสั่งนั้นๆ เเต่เมื่อ ระบบมีความซับซ้อนมากขึ้น หรือ เราอยากจะเพิ่มเติมฟังก์ชันไหน ถึงตอนนั้นเราจะสามารถทำได้อย่างยากลำบาก เพราะต้องจัดการกับโค้ดจำนวนมาก ) เพื่อที่จะแก้ปัญหานี้ จึงเกิดเป็นไอเดียของ machine learning หรือก็คือให้ machine เรียนรู้หรือปรับตัว (train) ให้เข้ากับข้อมูลหรือสภาพแวดล้อมที่ได้รับ (input data ) และ feature ที่สำคัญที่สุดที่จะนำมาซึ่ง AI ที่มีประสิทธิภาพ คือการมีข้อมูลที่เพียงพ่อต่อการ train ยกตัวอย่างเช่น AI สามารถเรียนรู้ได้หลากหลายภาษาตราบใดที่มีคำศัพท์ที่เพียงพอที่จะนำมา train

นอกจากนี้ AI ยังเป็นเทคโนโลยีที่ล้ำสมัยที่มีนักลงทุนจำนวนมากยอมที่จะเสี่ยงวางเงินหลักหลายล้านดอลลาร์ในการลงทุนใน startup หรือ project ที่เกี่ยวข้องกับ AI อีกทั้ง McKinsey ได้ทำการประเมินว่า AI จะทำการขับเคลื่อนทุกๆอุตสาหกรรมให้เติบโตในอัตรา 10 - 99 เปอร์เซนต์ เป็นอย่างน้อย